Ученые боятся, что роботы получат черты людей вместе с недостатками

Каждый из описанных ниже сценариев можно рассматривать как потенциально опасную линию развития при конце света. Итогом может стать доминирующее положение роботов на планете. Таким образом, восстание машин активно рассматривают ученые, однако случится ли подобное в действительности, остается под большим вопросом. Во-первых, одни из описываемых проблем предотвращаются работой разработчиков искусственного интеллекта, а во-вторых, ряд из вариантов конца света берет за основу достаточно фантастические предположения. Последние даже специально не получится реализовать по причине отсутствия соответствующих технологий.

Машины научатся лгать и хитрить при общении с людьми и друг другом

Сама по себе ложь является частью взаимодействия в обществе. Положительная ли это черта – вопрос дискуссионый, однако то, что данный механизм в общении помогает избежать определенных последствий или вызвать их «прямо сейчас», отрицать нельзя. Люди лгут довольно часто, при этом часть представителей животного мира также используют обман для обеспечения своего выживания. При этом уже сегодня данный механизм вводят в состав искусственного интеллекта.

Ученые, работающие в составе Технологического института Джорджии, создали роботов, которые могут лгать. Исследователи под руководством Рональда Аркина выразили надежду, что их роботы будут использоваться военными. После завершения разработки, машины получат возможность выходить на поле битвы вместе с военнослужащими. Предполагается использовать механизмы в качестве охранников, под защитой которых станут располагаться боеприпасы и провизия. В данном случае искусство лжи должно помочь ИИ «выиграть некоторое время до прибытия подкрепление». Помимо этого, механизм обмана позволит изменить стратегии патрулирования для обмана иных интеллектуальных машин либо людей.

Как признал один из разработчиков подобного механизма, при его реализации есть существенные проблемы в сфере этики. В частности, при использовании с целью целенаправленного вреда такая модель поведения искусственного интеллекта способна спровоцировать настоящую катастрофу, а после и привести к апокалипсису.

Роботы лишат людей рабочих мест

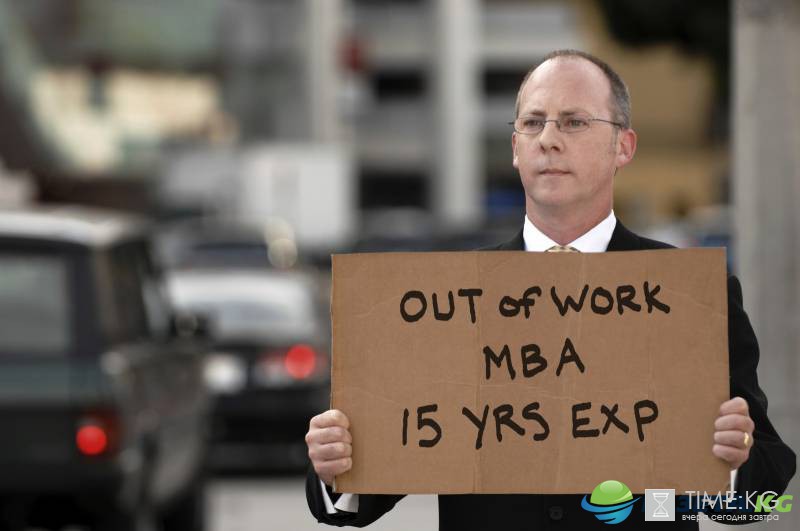

Это распространенная фобия у многих лиц. По количеству подверженных ей людей она с огромным отрывом обходит страх перед началом роботами против людей войны на уничтожение. Фактически, уверены ученые, для убийства множества людей никаких роботов с автоматами не понадобится. Достаточно лишить большую часть граждан работы и это спровоцирует падение уровня жизни, голод, а следом и множество смертей.

Для части экспертов подобный сценарий выглядит достаточно реальным, поскольку роботизация промышленности идет полным ходом и роль человека на различных производствах становится все меньше. К примеру, в США более 250 тысяч роботов занимаются работой, которую до этого выполняли люди. Многие ожидают, что первыми от подобной ситуации наиболее сильный удар ощутят страны с развитой сферой робототехники.

При этом беспокойство вызывает не только факт отъема рабочих мест из-за отсутствия необходимости в перерывах на еду, но и то, что искусственный интеллект способен делать лучше практически все. Исследователи напоминают, что сегодня даже интеллектуальные игры перестали быть местом лидерства человека. Шахматы и восточный аналог этой игры го уже испытаны роботами, обыгрывающими даже мировых чемпионов в этих видах спорта.

Многие учреждения попытались рассчитать вероятность наступления такого кризиса в отдельных странах. По данным исследования Оксфордского университета, за следующие 20 лет порядка 35% всех рабочих мест на территории Великобритании будут заняты машинами с искусственным интеллектом.

Машины станут злонамеренными хакерами

Во многих голливудских кинолентах хакеры атакуют системы безопасности и провоцируют различные катастрофы. Вплоть до того, что захватывают под свое управление различные системы инфраструктуры и берут население целой страны в заложники. В реальной жизни подобного не происходит, но если предположить, что суперкомпьютер с искусственным интеллектом и огромными вычислительными мощностями станет хакером, опасность реализации такого сценария возрастает на порядки.

Причина в том, что скорость реакции программы на изменение условий намного выше, чем у человека. Множество операция совершаются каждую тысячную секунды и это позволяет машинам быстрее проводить взлом разного рода систем. Еще большие опасения вызывают разработки продвинутых ИИ, которые станут бороться с «хакерами». Казалось бы, адаптируемая к взлому защита представляет собой идеальное решение, но в действительности тут есть множество подводных камней.

В частности, в августе прошлого года 7 команд стали участниками Cyber Grand Challenge, инициированного DARPA. Целью конкурса стало создание ИИ для взлома, способного атаковать уязвимости противников и параллельно обнаруживать собственные слабозащищенные места. С одной стороны, это достаточно защищенная система, а с другой – она может посчитать своей слабостью доступ оператора-человека и выявить методы для блокировки его входа. Таким образом, система станет автономной.

Какую после этого систему она посчитает для себя опасностью и решит атаковать? Возможные варианты пугают ученых достаточно сильно, особенно с учетом того, что есть варианты, при которых такой ИИ возьмет под контроль отдельные, нападающие на него хакерские модели и станет реализовать многостороннюю атаку на неугодные системы.

Понимание принципов поведения человека позволит ИИ гипнотизировать людей

Люди не всегда могут понять самих себя, но искусственному интеллекту это может оказаться под силу. Достаточно распространен пример Facebook, программы которого собирают сведения о пользователях и строят базы данных с предпочтениями отдельных лиц, на основе которых уже делают рекламные предложения и подбирают интересные посты.

Многие довольны подобным механизмом, однако на самом деле это открывает искусственному интеллекту возможности манипулирования людьми. Речь идет не просто о теме поста, но о множестве мельчайших деталей, цвете даже незначительных элементов и многом ином.

Как рассказал Марк Цукерберг, он планирует создать еще более развитый ИИ, который станет действовать в области медицины и других важнейших сферах. ИИ Facebook уже обучается распознаванию множества паттернов, однако в будущем он машина сможет улучшать себя.

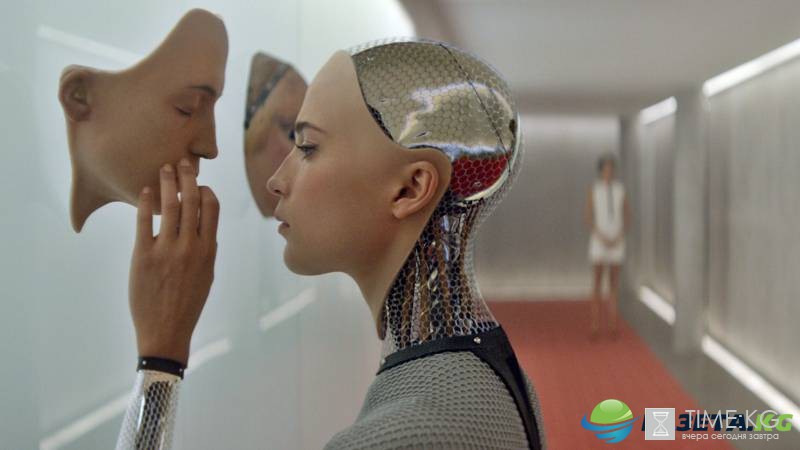

Роботы станут такими же как люди

Что будет если роботы станут крайне похожи на людей? Многие ученые считают, что одним из первых этапом их использования окажется внедрение в публичные дома. Если секс-услуги с использованием роботов станут нормой для людей, их отношение в рамках социума окажется заметно хуже, чем сегодня. Отдельно ученые ставят вопрос о формировании пар и семей. Которые могут распасться из-за завышенных ожиданий от второй половинки после встречи с максимально соответствующих конкретному вкусу роботов.

Чем больше машины похожи на людей, тем опаснее это для человечества, уверены исследователи. Сегодня уже созданы роботы, которые ведут себя так же как люди в ряде ситуаций. Они запоминают человека, могут вести с ним беседу и на основе собранных данных планировать последующий разговор. При этом распознавание мимики лица и знание типовых реакций позволят роботам вести себя подобно людям при налаживании диалога, избегать неприятных тем и становиться хорошими собеседниками.

Финальным аккордом среди фобий стало появление у роботов чувств. Именно это принято считать их главным отличием от людей. Первый шаг в разработке способной испытывать эмоции программы уже сделан. На базе непредсказуемой для стороннего человека реакции формируется образ максимально схожий с человеческим. На что именно будут готовы пойти роботы при появлении у них чувств? Ответить на этот вопрос сложно, но люди из-за эмоций нередко начинали войны и устраивали геноцид.

Автор: Валерий Антонов

Читайте также: